인공지능(AI) 모델을 개인 컴퓨터나 로컬 환경에 설치하는 준비 방법과 설치 전 기본 구성 요소 점검부터 실제 활용까지 실전 방법을 살펴봅니다.목표는 필요한 컴퓨터 AI 설치 방법의 전체 과정을 명확하게 파악하고, 성공적인 로컬 AI 환경을 구축할 수 있도록 하는 것입니다.

1. AI 설치 전 기본 환경 구성과 필수 조건 점검

처음 AI 모델 설치를 시도하는 분들은 무엇을 준비해야 할지 막막할 수 있습니다. 로컬 AI 설치의 핵심은 하드웨어 요구 사항을 정확히 파악하는 것입니다. 이 부분이 곧 설치 성공 여부를 결정합니다.

1.1. AI 설치의 기본 조건: GPU와 VRAM의 중요성

AI 모델, 특히 대규모 언어 모델(LLM)을 개인 컴퓨터에서 구동하려면 그래픽 처리 장치(GPU)와 그 메모리인 VRAM(Video RAM) 확보가 가장 중요합니다.

- VRAM 용량의 기준: 초보자가 가장 흔히 놓치는 부분입니다. 예를 들어, 7B 파라미터 규모의 모델을 원활하게 실행하려면 최소 4GB 이상의 VRAM이 필요하며, 더 큰 13B 모델은 8GB 이상의 VRAM이 권장됩니다. 이 기준은 단순한 추천이 아니라, 모델 로딩과 연산이 실제로 가능하게 하는 필수 조건입니다.

- 사전 점검: 따라서 AI 설치를 시도하기 전에 반드시 자신의 그래픽 카드 모델명과 VRAM 용량을 먼저 확인해야 합니다.

1.2. 설치 방식 선택: 로컬과 클라우드 방식의 비교

개인 컴퓨터 AI 설치는 크게 두 가지 방식으로 접근할 수 있으며, 자신의 목적과 환경에 맞춰 선택해야 합니다.

| 구분 | 설명 | 로컬 AI 설치 시 주의사항 |

| 로컬 설치 | 개인 PC 하드웨어 성능을 기반으로 직접 모델을 실행하는 방식. | VRAM 용량과 저장 공간 확보가 필수이며, 초기 설정 난이도가 상대적으로 높음. |

| 클라우드 설치 | 서버 자원(Google Colab, AWS 등)을 활용하는 방식. | 성능 걱정은 없으나 지속적인 비용이 발생하거나 인터넷 연결이 필수. |

AI 로컬 설치는 한 번 구축되면 자유도가 높고 인터넷 연결 없이도 사용할 수 있으며, 무엇보다 데이터 프라이버시를 완벽하게 유지할 수 있다는 장점이 있습니다.

2. AI 설치를 위해 컴퓨터 사양 점검 및 구조 이해

컴퓨터에 AI 설치의 성공은 컴퓨터 사양 점검에서 시작됩니다. 특히 GPU 유무와 성능은 AI 성능의 90%를 좌우하므로, 이 부분을 정확하게 이해하는 것이 필수입니다.

2.1. AI 성능을 위한 GPU 권장 기준

GPU는 LLM 추론 시 병렬 연산의 대부분을 담당합니다. GPU 메모리가 많을수록 더 큰 모델 구동과 빠른 응답 속도를 보장합니다.

| 구분 | 최소 사양 | 권장 사양 | AI 설치 관점 설명 |

| GPU | GTX 1650 이상 | RTX 3060 (12GB) 이상 | AI 모델 연산 처리 속도를 결정합니다. |

| VRAM | 4GB | 8GB ~ 12GB | VRAM 용량이 곧 구동 가능한 최대 모델 크기를 의미합니다. |

| RAM | 8GB | 16GB ~ 32GB | 모델 로딩 오류 방지 및 원활한 시스템 운영에 필요합니다. |

| 저장공간 | 20GB | 50GB 이상 | GGUF 파일과 여러 모델을 저장하기 위해 필요합니다. |

2.2. GPU가 없는 PC에서의 AI 설치 방법

일반 사용자들은 “GPU 없이도 AI 모델 설치가 가능한가?”라는 질문을 많이 합니다. 가능합니다. 단, 작고 가벼운 모델에 한해서만 가능하며, 속도는 상당히 느립니다.

- GPU 없는 PC 추천 모델: Phi-2, Qwen 0.5B ~ 2B, Gemma 2B 등 경량 모델 중심.

- 가능 작업: 간단한 채팅, 요약, 번역, 글쓰기 등 저연산 작업.

- 어려운 작업:이미지 생성 AI(Stable Diffusion 등)나 Llama 13B 이상의 대규모 모델 구동.

2.3. 내 컴퓨터 사양 확인하는 간단한 방법

AI 설치 준비를 위해 자신의 사양을 간단하게 확인하는 방법입니다.

- Windows 작업 관리자 활용: Ctrl + Shift + Esc를 눌러 작업 관리자를 열고 ‘성능’ 탭에서 GPU 모델명과 VRAM 용량을 확인합니다.

- 저장 공간 체크: AI 모델 파일인 GGUF 등의 파일 크기가 크므로, SSD/HDD 용량이 충분한지 확인합니다.

2.4. AI 선택하기 쉬운 AI 설치 방법

AI 모델 설치 방법은 복잡해 보일 수 있지만, 초보자에게는 다음과 같은 웹 인터페이스 기반 방식이 가장 추천됩니다.

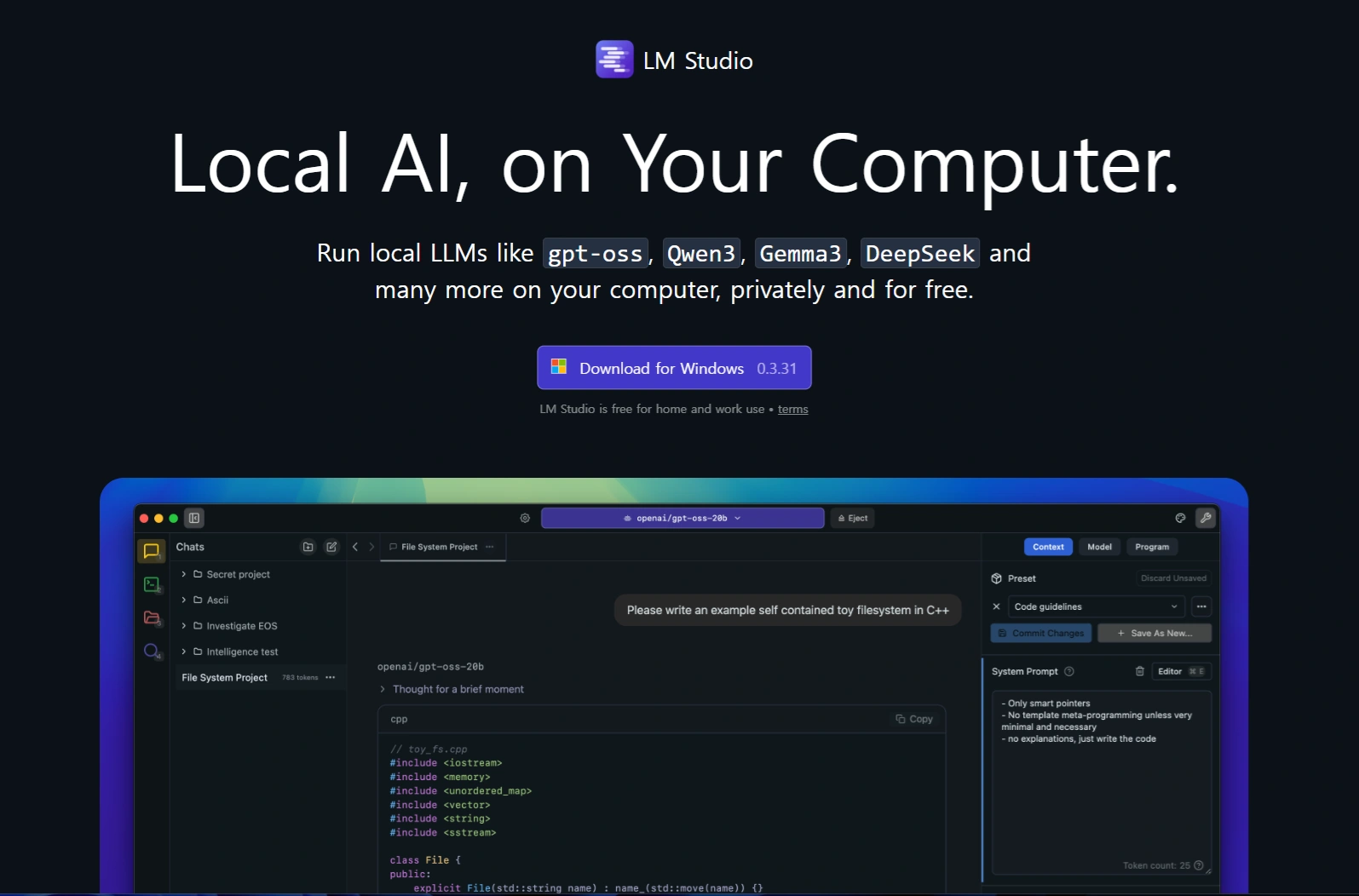

- LM Studio / Oobabooga / Ollama: 이러한 도구들은 설치 난이도를 대폭 낮추고, 사용자가 클릭 몇 번으로 모델을 다운로드하고 채팅 인터페이스를 통해 바로 테스트할 수 있게 해줍니다. 이 가이드에서 중점적으로 다룰 방식입니다.

- 개발자 버전 (Python + CUDA):Python 설치, 가상환경 생성, CUDA 설치 등 복잡한 과정을 거치며 자유도가 높지만, 초보자에게는 실패율이 높습니다.

3. 실전 AI 설치 단계: LM Studio 기반 (간단한 설치 추천)

가장 쉽게 컴퓨터에 AI 설치를 완료할 수 있는LM Studio 기반의 단계별 과정을 안내합니다.

3.1. 설치 전 필수 프로그램 및 준비 사항

AI 모델을 구동하기 위해 필요한 최소한의 환경을 구축합니다.

- NVIDIA 드라이버 및 CUDA 확인: GPU를 사용하려면 최신 NVIDIA 드라이버 설치가 필수입니다. 이는 CUDA 연동을 위해 필요합니다. (CPU만 사용 시 생략 가능)

- Python 및 Git (선택):LM Studio 사용 시 필수적이지는 않지만, 추후 Web UI나 개발자 모드를 사용하려면 Python 3.10 이상과 Git 설치가 필요합니다.

3.2. LM Studio를 이용한 모델 설치

LM Studio는 Hugging Face의 다양한 모델을 쉽게 탐색하고 로컬에 설치할 수 있게 돕는 올인원 도구입니다.

- LM Studio 다운로드 및 실행: 공식 웹사이트에서 앱을 다운로드하여 설치하고 실행합니다.

- 모델 검색 및 GGUF 파일 선택: 앱 내 검색 기능을 통해 원하는 LLM(예: Mistral)을 검색합니다. 로컬 실행에 최적화된 GGUF 확장자를 가진 파일을 선택합니다.

- Tip: 파일명에 있는 Q4_K_M 등은 양자화 레벨을 나타냅니다. 숫자가 낮을수록 용량이 작고 속도가 빠르지만, 성능 손실이 약간 발생할 수 있습니다. VRAM 용량에 맞춰 적절한 양자화 레벨을 선택합니다.

- 다운로드 및 로드: 선택한 파일을 다운로드합니다. 다운로드 완료 후 ‘모델 로드’ 탭에서 해당 모델을 선택합니다.

- GPU 오프로드 설정:VRAM 용량에 맞게 GPU 오프로드(GPU Offload) 레이어를 조정합니다. 이 설정을 통해 GPU를 최대한 활용하여 연산 속도를 높일 수 있습니다.

3.3. 모델 로드 및 테스트 (설치 성공의 확인)

AI 설치 후 가장 중요한 단계는 모델이 정상적으로 로드되고 반응하는지 확인하는 것입니다.

- 채팅 인터페이스 활용:‘채팅 탭’으로 이동하여 로드된 모델을 선택합니다.

- 프롬프트 입력: 간단한 질문(“안녕하세요, AI야”)을 입력하여 모델의 응답 속도와 일관성을 확인합니다.

- 점검 사항:GPT-7B 모델의 경우 보통 1~3초 내에 응답이 와야 정상적인 로컬 구동으로 간주됩니다. 응답이 너무 느리거나 오류 메시지가 뜨면 VRAM 부족이나 GPU 드라이버 문제를 의심해야 합니다.

4. AI 모델 최적화, 활용 사례 및 문제 해결

AI 설치가 완료되었다면, 이제 성능을 최적화하고 다양한 방법으로 활용할 차례입니다.

4.1. 하드웨어 및 소프트웨어 최적화 팁

- 모델 양자화(Quantization): 모델 크기를 줄여 RAM/VRAM 부담을 최소화하는 기술입니다. 초보자는 Q4나 Q5 레벨의 GGUF 파일을 사용하는 것이 가장 효율적입니다.

- GPU 활용 극대화: LM Studio의 GPU 오프로드 기능을 적극적으로 활용하여 GPU와 VRAM을 효율적으로 사용합니다.

- 가상환경 분리 (Python 설치 시): 여러 모델을 다룰 경우, Python 가상환경을 만들어 패키지 간의 충돌을 방지해야 AI 환경의 안정성을 유지할 수 있습니다.

4.2. 로컬 AI 모델의 실전 활용 사례

컴퓨터 AI 설치의 가장 큰 이점은 안전하고 자유로운 활용입니다.

- 데이터 프라이버시 유지: 민감한 문서 요약, 내부 코드 생성 등 모든 작업이 로컬 환경에서 이루어지므로 정보 유출 위험이 없습니다.

- 작업 자동화:OpenAI 호환 API 서버 기능을 활성화하면, 파이썬이나 다른 외부 애플리케이션에서 로컬 모델을 호출하여 반복적인 업무나 문서 자동화에 활용할 수 있습니다.

- 창의적 콘텐츠 제작: LLM을 기반으로 이미지 생성 AI와 연동하여 텍스트-이미지 콘텐츠 제작에도 활용될 수 있습니다.

4.3. 초보자가 흔히 겪는 문제와 해결 방법 (FAQ)

| 문제 유형 | 원인 | 해결 방법 |

| 모델 로드 실패 | VRAM 부족, 경로 공백, 권한 문제. | GPU 오프로드 설정 조정, 양자화 낮은 모델 선택, 파일 경로 확인. |

| 응답 속도 느림 | 모델 크기 과다 또는 CPU 연산 의존. | 작은 모델로 변경하거나 GPU 오프로드 설정을 늘립니다. |

| 오류 메시지 발생 | 패키지 충돌 (개발자 모드 시) 또는 드라이버 문제. | 가상환경을 재설치하거나 NVIDIA 드라이버를 최신 버전으로 업데이트합니다. |

컴퓨터 AI 설치는 더 이상 전문가의 영역이 아닙니다. LM Studio와 같은 도구를 통해 초보자도 하드웨어 기본 조건만 갖춘다면 누구나 자신만의 로컬 AI 환경을 구축하고, 개인 정보 걱정 없이 무한한 활용을 시작할 수 있습니다.

Q1: 컴퓨터에 AI 설치방법을 따라 했는데 모델이 로드되지 않습니다. 왜 그런가요?

A1: 대부분 VRAM 부족이나 GGUF 파일 손상 문제입니다. GPU 오프로드를 줄이거나, 양자화 레벨이 낮은 모델을 선택해 보세요. 또한, 파일 경로에 한글이나 특수 문자가 없도록 해야 합니다.

Q2: 설치한 AI 모델을 인터넷 연결 없이 사용할 수 있나요?

A2: 예, 로컬 설치 모델은 인터넷 없이도 사용 가능합니다. 다만 초기 다운로드와 업데이트 시 인터넷 연결이 필요합니다.

Q3: OpenAI 호환 API 서버를 연동하면 외부 프로그램에서도 사용할 수 있나요?

A3: 네, 파이썬, 자바스크립트, 기타 API 호출 가능한 프로그램에서 localhost 서버를 통해 모델을 사용할 수 있습니다.

Q4: 초보자가 처음 설치할 때 가장 주의할 점은 무엇인가요?

A4: 컴퓨터에 AI 설치방법 과정에서 파일 용량과 VRAM 요구 사항을 확인하는 것이 가장 중요합니다. 모델 선택 시 PC 사양을 고려해야 설치 오류를 방지할 수 있습니다.

Q5: 여러 모델을 설치했을 때, 자원을 효율적으로 사용하는 방법은?

A5: 사용하지 않는 모델은 로드하지 않고 필요할 때만 로드하며, GPU 오프로드 설정을 조정해 VRAM 사용량을 최소화하는 것이 좋습니다.

누구나 컴퓨터에 AI 설치방법을 통해 로컬에서 모델을 실행하고, 테스트하며, 업무에 활용할 수 있습니다.