블로그에 AI로 자동화, 키워드 추출, SEO 최적화 방법: TensorFlow.js 기반 AI로 방문자와 상호작용하며, 검색 엔진에 최적화된 요약과 핵심 키워드를 자동 생성합니다.

블로그를 운영하면서 방문자들에게 단순히 콘텐츠를 읽는 경험을 넘어 ‘대화하고 반응하는 경험’을 제공하고 싶으신가요? 매번 서버와의 데이터 왕복(Round Trip)으로 사용자가 직접 코딩하고 기다려야 했던 ‘어려운 AI’는 이제 잊으셔도 좋습니다.

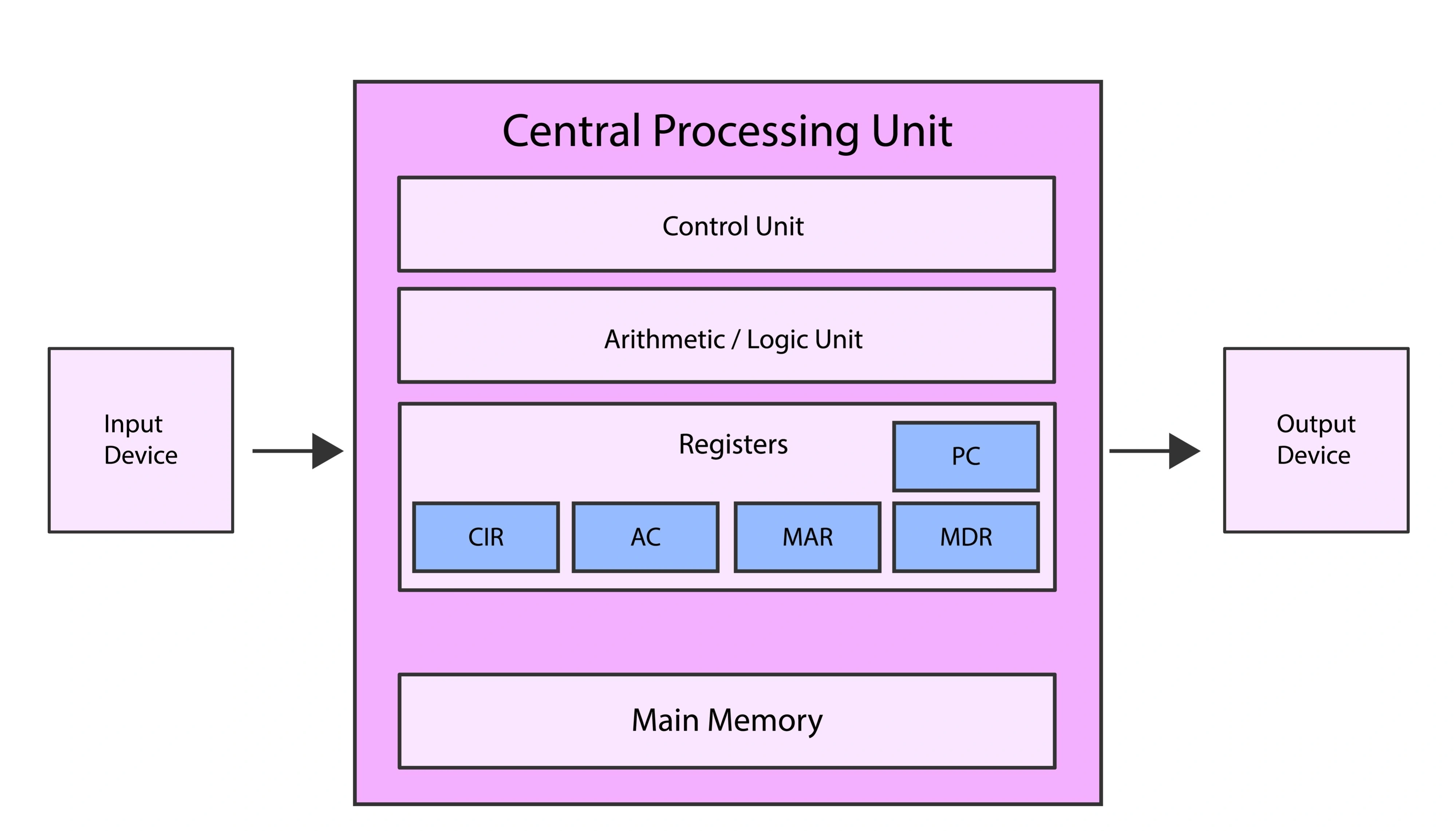

TensorFlow.js는 웹 환경에서 딥러닝 모델을 직접 실행할 수 있게 해주는 라이브러리이자, 블로그에 AI를 통합하는 가장 효율적인 방법입니다.

이번에는 TensorFlow.js의 핵심 가치인 저지연(Low Latency),데이터 프라이버시, 그리고 웹 GPU 가속을 통한 성능 극대화 전략을 심층적으로 다루며, 블로그를 위한 브라우저 머신러닝에 대해 알아봅니다.

TensorFlow.js: 블로그를 위한 브라우저 머신러닝의 새로운 표준

혹시 ‘블로그에 AI를 접목’하고 싶은데, 기술적 어려움,속도,장비 때문에 망설이셨나요? 불과 몇 년 전만 해도 딥러닝 모델을 실행하려면 반드시 강력한 서버나 클라우드 GPU 자원이 필요했습니다. 블로그나 사이트에 AI 기능을 넣으려고 할 때마다, 사용자 요청은 먼 서버를 왕복해야 했고, 그 시간(‘왕복 시간’, Round Trip Time)만큼 독자들은 지연을 감수해야 했죠. 특히 해외 독자가 많을 경우 이 네트워크 지연(Latency)은 콘텐츠의 몰입도를 떨어뜨리는 가장 큰 장벽이었습니다.

하지만 TensorFlow.js의 등장은 이 모든 고민을 과거형으로 만들었습니다. 이 JavaScript 기반의 라이브러리는 웹 브라우저에서 딥러닝 모델을 직접 실행하고, 심지어 간단한 전이 학습(Transfer Learning)까지 가능하게 합니다.

TensorFlow.js는 AI 연산의 중심을 서버가 아닌 사용자 개인의 기기(블로그, 사이트 등)에 사용하는 클라이언트 측 AI 시대를 열었습니다. 이제 복잡한 서버 설정이나 비용 부담 없이도 웹 프론트엔드에 실시간 AI 기능을 통합할 수 있습니다.

이는 블로그 AI 활용의 배포 속도와 접근성을 획기적으로 개선하며, 기존 Python으로 훈련된 모델도 웹 환경에 쉽고 빠르게 적용할 수 있습니다.

블로그 AI 활용의 핵심: 클라이언트 측 AI가 제공하는 3가지 이점

우리의 블로그에 TensorFlow.js를 선택해야 하는 명확하고도 매력적인 세 가지 이유는 다음과 같습니다. 이는 단순히 기술적 효율성을 넘어, 독자 경험(UX)과 운영 효율성 모두를 얻을 수 있는 윈-윈(Win-Win) 전략입니다.

- 1. 압도적인 저지연(Low Latency)으로 실시간 반응: AI 연산이 브라우저 내에서 즉시 처리되니, 서버 왕복으로 인한 네트워크 지연이 제로(0)에 가까워집니다. 독자가 스크린샷을 올리자마자 바로 분석 결과를 제공하거나, 댓글 작성 중 실시간 문장 완성을 지원하는 등 인터랙티브한 블로그 환경을 구축할 수 있습니다. 이는 실시간 웹 AI를 구현하는 데 필수적입니다.

- 2. 데이터 프라이버시의 완벽한 수호자: 블로그 AI 활용 시 가장 민감한 부분이 데이터 유출입니다. TensorFlow.js는 민감한 사용자 데이터(예: 입력 텍스트, 웹캠 데이터)가 외부 서버로 전송될 필요 없이 로컬에서만 처리하도록 합니다. 독자들의 프라이버시를 완벽히 보호하는 것은 사용자 신뢰 구축에 결정적인 역할을 합니다.

- 3. 운영 비용 및 서버 부하의 획기적인 절감: AI 추론 연산을 방문자 개인의 기기로 분산시키면, 블로그 운영자는 고성능 서버의 GPU/CPU 비용 부담에서 벗어날 수 있습니다. 특히 트래픽이 많은 인기 블로그일수록, 이 클라이언트 측 AI 전략은 운영 비용 절감 효과를 극대화합니다.

블로그 성능 최적의 비밀: 웹 GPU 가속과 tfjs 관리법

여전히 ‘브라우저에서 딥러닝이 과연 빠를까?‘라는 의문이 남을 수 있습니다. TensorFlow.js가 고성능을 유지하는 비결은 바로 웹 표준 그래픽 기술을 활용하는 데 있습니다. WebGL 또는 최신 WebGPU 기술은 JavaScript를 통해 사용자의 그래픽 처리 장치(GPU)에 접근하여 딥러닝 연산의 핵심인 행렬 곱셈과 컨볼루션을 병렬 처리합니다.

대부분의 경우 TensorFlow.js 라이브러리가 이 웹 GPU 가속 기능을 자동으로 사용하게 해주지만, 최고의 성능을 유지하기 위한 tfjs 성능 최적화 전략은 필수입니다.

- 모델 경량화와 양자화(Quantization): 블로그 방문자는 주로 모바일 기기를 사용합니다. 따라서 MobileNet 같은 경량 모델을 사용하고, 모델의 가중치를 32비트 부동 소수점에서 8비트 정수로 압축하는 양자화(Quantization) 기법을 적용해야 합니다. 모델이 가벼워야 로딩 시간이 단축되고, AI 경험이 즉각적으로 느껴집니다.

- 결정적인 메모리 관리 (tf.tidy): 텐서(Tensor)는 GPU 메모리를 사용합니다. 연산 후 사용하지 않는 텐서를 명시적으로 해제하지 않으면 메모리 누수가 발생하여 브라우저가 느려지거나 멈출 수 있습니다. 이를 방지하기 위해

tf.dispose()를 사용하거나, 연산 블록 전체를tf.tidy()로 감싸서 메모리를 깔끔하게 정리하는 것이 가장 중요한 성능 최적화 요소입니다.

실전 AI 접목 및 SEO 강화 전략: 동적 콘텐츠 처리와 핵심 추출

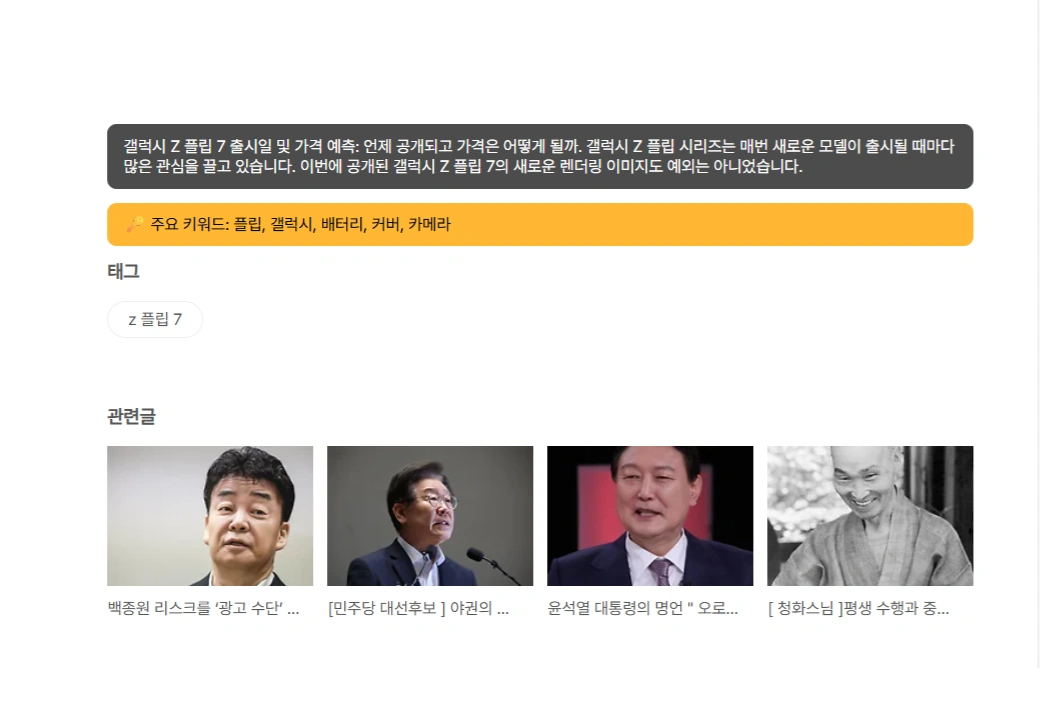

블로그에 TensorFlow.js를 적용할 때, 사용자가 스크롤하거나 댓글이 비동기적으로 로드되는 동적 콘텐츠에 AI 연산을 안정적으로 적용하는 것이 핵심입니다. 더 나아가, AI가 생성한 고품질의 정보(콘텐츠 요약, 핵심 키워드)를 검색 엔진 최적화(SEO)에 활용하는 전략은 블로그 효율성을 상승시킵니다.

- 단일 모델 로드 패턴: TensorFlow.js 모델은 초기 로딩 시 리소스를 소모합니다. 페이지가 로드될 때 모델을 단 한 번만 불러오는 Lazy Loading 또는 Singleton Pattern을 적용하여 중복 로딩을 방지하고 tfjs 성능 최적화를 유지해야 합니다.

- 동적 콘텐츠 감지 (MutationObserver): 댓글이나 늦게 로드되는 본문 같은 동적 요소에는 MutationObserver API를 사용하여 새로운 DOM 요소가 추가될 때마다 AI 처리 로직(예: 댓글 감성 분석, 요약)을 실행해야 합니다. 이 방식이 바로 AI 기능을 안정적으로 작동시키는 열쇠입니다.

데이터 처리 플래그와 AI 기반 SEO 코드 적용

AI 연산이 완료된 요소에 dataset.aiProcessed = 'true'와 같은 데이터 플래그를 설정하여 중복 연산을 방지합니다. 더욱 중요한 것은, AI가 생성한 본문 요약 및 핵심 키워드를 HTML DOM의 중요한 위치에 삽입하여 검색 엔진 봇(Crawler)이 해당 정보를 놓치지 않고 인덱싱하도록 유도하는AI 기반 SEO 전략입니다.

실제 간단한 적용 사례 및 코드

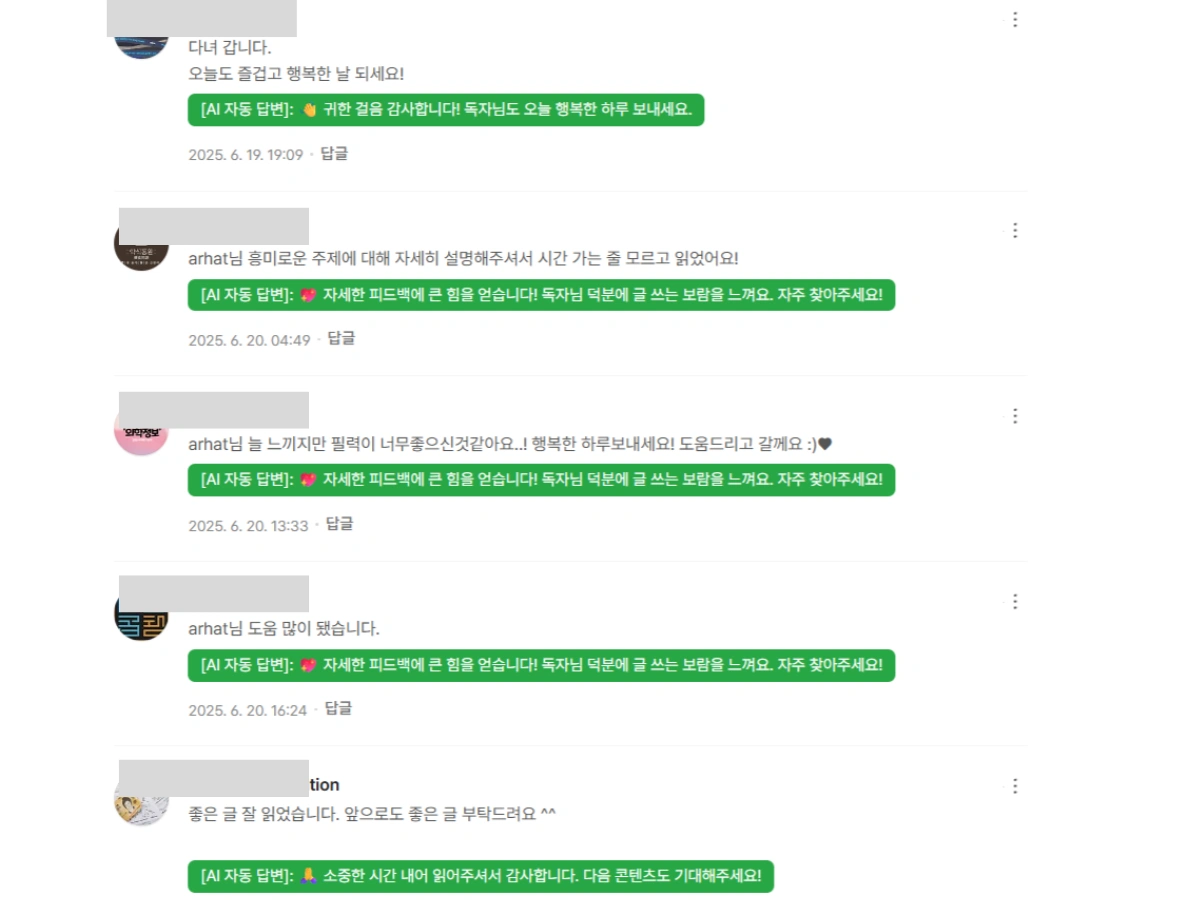

블로그에 달린 댓글을 AI가 분석하여, 사용자가 일일이 답글을 작성하지 않아도 자동으로 적절한 답변을 생성해 줍니다.

적용한 블로그: https://openpc.tistory.com/920

적용 코드 예제

아래 예시 코드는 TensorFlow.js와 USE 모델을 활용하여 본문 요약 및 키워드를 생성하고, 이를 페이지의 중요한 위치에 삽입하여 SEO를 강화하는 실제적인 방법론을 보여줍니다.

script

(async () = {

let model;

try {

model = await use.load();

console.log("✅ AI 모델 로드 완료");

} catch(e) {

console.warn("⚠ AI 모델 로드 실패, 요약 기능은 간단 방식으로 동작");

}

async function generateResponse(text) {

return tf.tidy(() = {

const lowerText = text.toLowerCase();

if (lowerText.includes("질문") || lowerText.includes("궁금") || lowerText.includes("어떻게") || lowerText.includes("오류") || lowerText.includes("문제") || lowerText.includes("안되")) {

const responses = [

" 소중한 피드백/질문 감사합니다. 해당 내용 확인 후 답변 또는 수정 조치하겠습니다.",

"❓ 문의/제안 감사합니다. 내용을 주의 깊게 검토 후 빠른 시간 내에 해결책을 제시해 드리겠습니다."

];

return responses[Math.floor(Math.random() * responses.length)];

}

if (lowerText.includes("필력") || lowerText.includes("흥미로운 주제") || lowerText.includes("도움 많이 됐") || lowerText.includes("너무좋") ) {

const responses = [

" 자세한 피드백에 큰 힘을 얻습니다! 독자님 덕분에 글 쓰는 보람을 느껴요. 자주 찾아주세요!",

" 독자님의 칭찬에 어깨가 들썩이네요! 다음 글도 기대를 저버리지 않도록 노력하겠습니다.",

" 독자님께 도움이 되었다니 정말 기쁩니다! 언제나 유익한 정보를 전달해 드릴게요."

];

return responses[Math.floor(Math.random() * responses.length)];

}

if (lowerText.includes("다녀 갑니다") || lowerText.includes("즐거운 날 되세요") || lowerText.includes("행복한 하루") || lowerText.includes("도움드리고 갈께요")) {

const responses = [

" 귀한 걸음 감사합니다! 독자님도 오늘 행복한 하루 보내세요.",

"✨ 응원 감사합니다! 방문해주신 독자님께도 즐거운 일만 가득하시길 바랍니다.",

" 따뜻한 인사 감사합니다! 다음에 또 좋은 글로 찾아뵙겠습니다."

];

return responses[Math.floor(Math.random() * responses.length)];

}

if (lowerText.includes("감사합니다") || lowerText.includes("잘 보고") || lowerText.includes("잘 읽었습")) {

const responses = [

" 소중한 시간 내어 읽어주셔서 감사합니다. 다음 콘텐츠도 기대해주세요!",

" 공감해주셔서 감사드립니다! 다음 글에서 또 뵙겠습니다.",

" 독자님의 응원 메시지 잘 받았습니다! 항상 좋은 정보로 보답하겠습니다."

];

return responses[Math.floor(Math.random() * responses.length)];

}

const defaultResponses = [

" 소중한 의견 감사합니다. 다음에도 꼭 다시 찾아주세요.",

" 관심을 가져주셔서 감사합니다. 독자님의 의견을 참고하여 다음 글에 반영하겠습니다.",

"✨ 방문해 주셔서 감사합니다! 좋은 하루 되세요."

];

return defaultResponses[Math.floor(Math.random() * defaultResponses.length)];

});

}

let commentProcessing = false;

async function processComments() {

if(commentProcessing) return;

commentProcessing = true;

const container = document.querySelector(".tt-comments-wrap");

if(!container) {

commentProcessing = false;

return;

}

const comments = container.querySelectorAll(".tt_desc");

for(const c of comments) {

if(c.dataset.aiResponded) continue;

try {

const response = await generateResponse(c.innerText);

const div = document.createElement("div");

div.className = "ai-comment-response";

div.style = `

margin-top:6px;

padding:5px 10px;

background:#28a745;

color:#fff;

font-size:13px;

border-radius:6px;

display:inline-block;

`;

div.innerText = "[AI 자동 답변]: " + response;

c.parentElement.appendChild(div);

c.dataset.aiResponded = "true";

} catch(e) {

console.error("AI 답변 생성 오류:", e);

}

}

commentProcessing = false;

}

async function summarizeText(text, topN=3) {

const cleanText = text.replace(/br/g," ").replace(/

/g," ").trim();

const sentences = cleanText.split(/[.?!]/).map(s = s.trim()).filter(s = s.length 5);

if(sentences.length = 1) return cleanText;

return sentences.slice(0, topN).join(". ") + ".";

}

function extractKeywords(text, topN=5) {

const cleanText = text.replace(/br/g," ").replace(/

/g," ").toLowerCase();

const words = cleanText.match(/[가-힣a-zA-Z0-9]+/g) || [];

const freq = {};

words.forEach(w = { if(w.length1) freq[w]=(freq[w]||0)+1; });

const sorted = Object.entries(freq).sort((a,b)=b[1]-a[1]);

return sorted.slice(0,topN).map(e=e[0]);

}

async function processArticle() {

const article = document.querySelector(".tt_article_useless_p_margin.contents_style");

if(!article) return;

const summaryTarget = document.querySelector("#summary-target") || article;

if(!summaryTarget.querySelector(".ai-article-summary")) {

const summary = await summarizeText(article.innerText);

const div = document.createElement("div");

div.className = "ai-article-summary";

div.style = `

margin:12px 0;

padding:10px 14px;

background: rgba(0,0,0,0.7);

color: #fff;

font-size:14px;

border-radius:8px;

`;

div.innerText = summary;

summaryTarget.appendChild(div);

}

const keywordTarget = document.querySelector("#keyword-target") || article;

if(!keywordTarget.querySelector(".ai-article-keywords")) {

const keywords = extractKeywords(article.innerText);

const div = document.createElement("div");

div.className = "ai-article-keywords";

div.style = `

margin:12px 0;

padding:10px 14px;

background: rgba(255,165,0,0.8);

color: #000;

font-size:14px;

border-radius:8px;

`;

div.innerText = " 주요 키워드: " + keywords.join(", ");

keywordTarget.appendChild(div);

}

}

const observer = new MutationObserver(() = {

setTimeout(processComments, 300);

setTimeout(processArticle, 300);

});

observer.observe(document.body, {childList:true, subtree:true});

processComments();

processArticle();

})();

/script