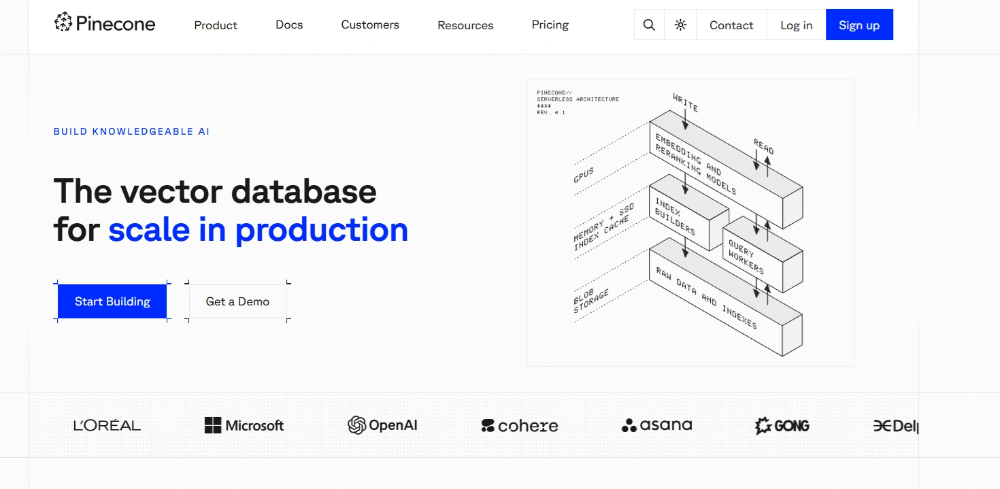

Pinecone은 AI 벡터 데이터베이스는, 대규모 언어 모델(LLM) 기반의 RAG (검색 증강 생성) 시스템 및 추천 시스템을 빠르고 정확하게 구축할 수 있는 완전 관리형(Fully Managed) 고성능 데이터 플랫폼 솔루션입니다.

AI 기술이 발전하면서 방대한 비정형 데이터를 효율적으로 처리하고 의미 기반 검색(Semantic Search)을 구현하는 것이 핵심 과제가 되었습니다. Pinecone은 이러한 AI 애플리케이션과 벡터 검색을 위해 최적화된 벡터 데이터 플랫폼으로, 개발자와 기업이 빠르고 정확한 검색 엔진, 추천 시스템, 자연어 처리(NLP) 서비스를 쉽게 구축할 수 있도록 지원합니다.

오늘은 AI를 활용하기 위해 필수적인 기본 자료, 특히 비정형 데이터를 벡터 데이터베이스로 효율적으로 관리하고 RAG 파이프라인에 활용하는 방법에 대해 자세히 알아보겠습니다.

AI 벡터 데이터베이스 Pinecone이란 무엇이며, LLM RAG에 필수적인 이유?

Pinecone은 텍스트, 이미지, 오디오 등의 비정형 데이터를 고차원 임베딩 벡터로 변환하여 저장하고, 이를 기반으로 효율적인 유사도 검색 및 AI 추천 기능을 제공하는 클라우드 기반 관리형 벡터 데이터베이스입니다. 기존의 SQL 기반 관계형 데이터베이스(RDBMS)나 NoSQL 데이터베이스는 키워드나 키-값 조회에 강점이 있지만, 데이터의 의미를 파악하는 벡터 검색 및 유사도 계산에는 근본적인 한계가 있습니다.

Pinecone은 일반적인 데이터베이스가 아닌, 임베딩 벡터(Embedding Vector)를 대규모로 저장하고 고속으로 검색하기 위해 설계된 특화된 데이터베이스입니다. 특히 Approximate Nearest Neighbor (ANN) 알고리즘을 활용하여 유사도 기반 검색에 극도로 최적화되어 있습니다. 따라서 RAG 시스템 구축, 이미지 검색, 문서 검색, 챗봇, 개인화 추천 시스템 등 AI 애플리케이션 구축에 있어 성능과 확장성 면에서 필수적인 플랫폼으로 인정받고 있습니다.

AI 벡터 데이터베이스 Pinecone의 주요 기능 및 장점 (RAG 최적화)

| 기능 | 설명 |

|---|---|

| 고속 벡터 검색 | 수십억 개의 벡터를 대상으로도 밀리초 단위의 빠른 검색 속도를 제공하며, 가장 유사한 벡터를 실시간으로 탐색할 수 있습니다. |

| 완전 관리형 서비스 | 서버 관리, 인프라 설정, 인덱싱 최적화 등의 복잡한 작업 없이, Pinecone이 자동으로 확장(Scaling), 관리, 최적화하여 개발 부담을 최소화합니다. |

| AI & LLM 통합 | Python SDK, REST API를 제공하며, LangChain 등 다양한 ML/AI 프레임워크와 완벽하게 호환되어 LLM 기반 RAG 파이프라인과 쉽게 연결됩니다. |

| 뛰어난 확장성 | 데이터 볼륨이 증가하거나 트래픽이 몰려도 자동 확장이 가능하여, 수십억 개의 벡터 처리를 안정적으로 수행할 수 있는 엔터프라이즈급 플랫폼입니다. |

| 높은 정확도 | HNSW 등 효율적인 벡터 인덱싱 및 최적화된 검색 알고리즘을 통해 정확한 유사도 기반 결과를 제공하여 AI 답변의 품질을 향상시킵니다. |

Pinecone AI 데이터 활용 분야 및 방법

AI 엔지니어와 기업은 Pinecone을 활용해 고도화된 AI 기반 애플리케이션을 신속하게 구축할 수 있습니다.

- RAG (검색 증강 생성): LLM의 지식을 최신 또는 사내 데이터로 확장하여 환각(Hallucination) 현상을 줄이고 답변의 정확도를 높입니다.

- 개인화 추천 시스템: 사용자 행동 패턴이나 아이템 정보를 벡터로 변환하여 맞춤형 콘텐츠 및 상품 추천을 제공합니다.

- 자연어 처리 (NLP) 검색: 문서, FAQ, 고객 문의 데이터에서 의미 기반 검색과 유사도 판단을 수행하여 정확한 정보를 제공합니다.

- 멀티모달 검색: 이미지, 오디오 등의 특징 벡터를 기반으로 시각적/청각적 유사한 콘텐츠를 고속 검색합니다.

- AI 기반 데이터 분석: 대규모 비정형 데이터셋에서 의미 있는 패턴과 인사이트를 효과적으로 추출합니다.

Pinecone은 단순한 벡터 저장소를 넘어, AI 서비스 최적화를 위한 통합 관리형 플랫폼입니다. 사용자는 인프라 관리 부담 없이 AI 모델과 벡터 데이터 간 연결에 집중할 수 있으며, 빠르고 정확한 벡터 검색 결과로 최종 사용자 경험(UX)을 극대화할 수 있습니다. 또한 Pinecone은 엔터프라이즈급 확장성과 안정성을 제공하여 대규모 서비스 환경에서도 중단 없이 안정적으로 운영할 수 있습니다.

AI 기반 애플리케이션을 개발하거나 고성능 데이터 검색 및 추천 시스템을 구축하려는 기업과 개발자에게 Pinecone은 필수적인 벡터 데이터 솔루션이 될 것입니다.

Pinecone AI 벡터 데이터 사용 방법 (개발자 가이드)

회원가입 및 프로젝트 설정

Pinecone 공식 사이트에 접속해서 회원가입을 완료합니다.

인덱스 및 임베딩 모델 선택 (LLM 최적화)

새로운 인덱스(Index) 프로젝트를 생성하고, 임베딩 모델은 성능과 다국어 지원이 뛰어난 (예: multilingual-e5-large)를 선택하여 벡터 차원(Dimension)을 지정합니다.

이 모델은 텍스트를 1024차원의 임베딩 벡터로 변환하는 데 사용됩니다.

API 키 및 환경 주소 확인

가입 후 제공되는 API 키와 생성된 Pinecone 환경 주소(Host URL)를 확인하고 안전하게 보관합니다. 이 정보는 데이터 업로드 및 벡터 검색 요청 시 사용됩니다.

필수 Python 패키지 설치

파이썬 개발 환경에서 아래 명령어를 사용하여 Pinecone 벡터 데이터베이스 연동에 필요한 핵심 도구들을 설치합니다.

pip install pinecone sentence-transformers requests beautifulsoup4 tqdm

- Pinecone 클라이언트: 벡터 데이터 업로드(Upsert) 및 유사도 검색(Query) 수행

- Sentence Transformers: 고품질 텍스트 임베딩 생성 (텍스트를 벡터로 변환)

- BeautifulSoup4 / Requests: RAG 데이터 소스(예: 블로그, 문서) 스크래핑 및 수집

- tqdm: 대용량 데이터 처리 시 진행률 표시

데이터 수집 및 벡터화 코드 적용

아래 샘플 파이썬 코드를 수정하여 Pinecone 인덱스에 데이터를 업로드하는 작업을 수행합니다. API 키, Pinecone 주소, 데이터 소스 주소 등을 환경에 맞게 설정해야 합니다.

이 코드는 웹상의 블로그 콘텐츠를 추출하여 AI용 벡터 데이터로 변환하고 Pinecone에 배치 업로드하는 RAG 데이터 전처리 예제입니다.

샘플 Python 코드 (Ingestion Script)

import requests

from bs4 import BeautifulSoup

from sentence_transformers import SentenceTransformer

from tqdm.auto import tqdm

import re

# =================================================================

# 설정: API KEY, HOST, 임베딩 모델 정보 설정

# =================================================================

API_KEY = "YOUR_PINECONE_API_KEY"

PINECONE_HOST = "https://your-pinecone-instance.svc..pinecone.io"

EMBEDDING_MODEL_NAME = 'intfloat/multilingual-e5-large' # 고성능 다국어 임베딩 모델

BLOG_DOMAIN = "https:블로그 주소"

EMBEDDING_DIMENSION = 1024 # 모델이 생성하는 벡터 차원 (multilingual-e5-large 기준)

# 임베딩 모델 초기화

model = SentenceTransformer(EMBEDDING_MODEL_NAME)

# =================================================================

# 사이트맵에서 포스트 URL 수집 함수

# =================================================================

import xml.etree.ElementTree as ET

def parse_post_urls_from_xml_number(url):

urls = set()

try:

response = requests.get(url, timeout=15)

response.raise_for_status()

content = response.content.decode('utf-8')

content = re.sub(r'xmlns="[^"]+"', '', content)

root = ET.fromstring(content)

for element in root.findall('.//loc'):

loc_url = element.text

if loc_url:

# /숫자 형식의 URL만 필터링 (게시글 식별)

if re.search(r'/d+$', loc_url) and not any(keyword in loc_url for keyword in ['/category', '/pages', '/tag', '/guestbook']):

urls.add(loc_url.split('?')[0])

return urls

except Exception as e:

print(f" 사이트맵 파싱 오류 ({url}): {e}")

return set()

def get_post_urls_from_sitemap(blog_domain):

sitemap_url = f"{blog_domain}/sitemap.xml"

print(f"[{sitemap_url}]에서 RAG 데이터 소스 URL을 수집합니다...")

post_urls = parse_post_urls_from_xml_number(sitemap_url)

print(f" 사이트맵 파싱에서 총 {len(post_urls)}개의 게시글 URL을 찾았습니다.")

return list(post_urls)

# =================================================================

# HTML에서 콘텐츠 파싱 (데이터 전처리) 함수

# =================================================================

def scrape_blog_content(url):

title = "제목 없음"

content = ""

canonical_url = url

try:

response = requests.get(url, timeout=15)

response.raise_for_status()

html = response.text

soup = BeautifulSoup(html, 'html.parser')

# canonical URL 추출

canonical_tag = soup.find('link', rel='canonical')

if canonical_tag and 'href' in canonical_tag.attrs:

canonical_url = canonical_tag['href'].split('?')[0]

# 콘텐츠가 포함된 핵심 div 추출 (데이터 전처리)

main_div = soup.find('div', class_='tt_article_useless_p_margin contents_style')

if main_div:

# 제목 추출 및 제거

h1_tag = main_div.find('h1')

h2_tag = main_div.find('h2')

if h1_tag:

title = h1_tag.get_text(strip=True)

h1_tag.decompose()

elif h2_tag:

title = h2_tag.get_text(strip=True)

h2_tag.decompose()

# 정리된 텍스트 추출

content = main_div.get_text(separator='

', strip=True)

else:

print(f"⚠ 콘텐츠 div 없음: {url}")

return title, content, canonical_url

except Exception as e:

print(f" HTML 파싱 오류 ({url}): {e}")

return "오류 발생", "", url

# =================================================================

# Pinecone REST API를 이용한 벡터 배치 업로드 (Upsert) 함수

# =================================================================

import json

import requests

def upsert_batch_via_rest(vectors_batch):

"""벡터 배치를 Pinecone 인덱스에 업로드합니다."""

url = f"{PINECONE_HOST}/vectors/upsert"

# 네임스페이스는 필요에 따라 설정 가능 (RAG 등에서 데이터 분리 용도)

payload = {"vectors": vectors_batch, "namespace": ""}

headers = {"Api-Key": API_KEY, "Content-Type": "application/json"}

try:

response = requests.post(url, headers=headers, json=payload, timeout=30)

response.raise_for_status()

return response.json()

except requests.exceptions.RequestException as e:

print(f"

Pinecone Upsert 오류 발생: {e}")

return None

# =================================================================

# 메인 함수 (전체 실행 로직)

# =================================================================

def main():

post_urls = get_post_urls_from_sitemap(BLOG_DOMAIN)

if not post_urls:

print(" 수집할 포스트 URL이 없습니다. 스크립트를 종료합니다.")

return

upserts = []

for url in tqdm(post_urls, desc="포스트 처리 및 임베딩 생성 중"):

title, content, canonical_url = scrape_blog_content(url)

if content and title != "오류 발생":

# 벡터 ID는 URL의 마지막 숫자로 설정 (고유 식별자)

vector_id = canonical_url.split('/')[-1]

try:

# Sentence Transformer를 사용하여 텍스트를 벡터로 인코딩

embedding = model.encode(content).tolist()

except Exception as e:

print(f"임베딩 생성 오류 (벡터화 실패): {e}")

continue

# Pinecone 업로드용 데이터 형식

upserts.append({

'id': vector_id,

'values': embedding,

'metadata': { # 메타데이터는 검색 결과에 함께 반환됨 (RAG에서 필수)

'text': content,

'title': title,

'url': canonical_url

}

})

if upserts:

print(f"

총 {len(upserts)}개의 임베딩 벡터를 Pinecone에 업로드합니다...")

# 100개 단위로 배치 업로드하여 효율성 높이기

for i in tqdm(range(0, len(upserts), 100), desc="Pinecone 벡터 데이터 업로드 중"):

batch = upserts[i:i + 100]

upsert_batch_via_rest(batch)

print("

AI 벡터 데이터 업로드 완료! 이제 유사도 검색을 수행할 수 있습니다.")

else:

print("업로드할 유효한 데이터가 없습니다.")

if __name__ == "__main__":

main()

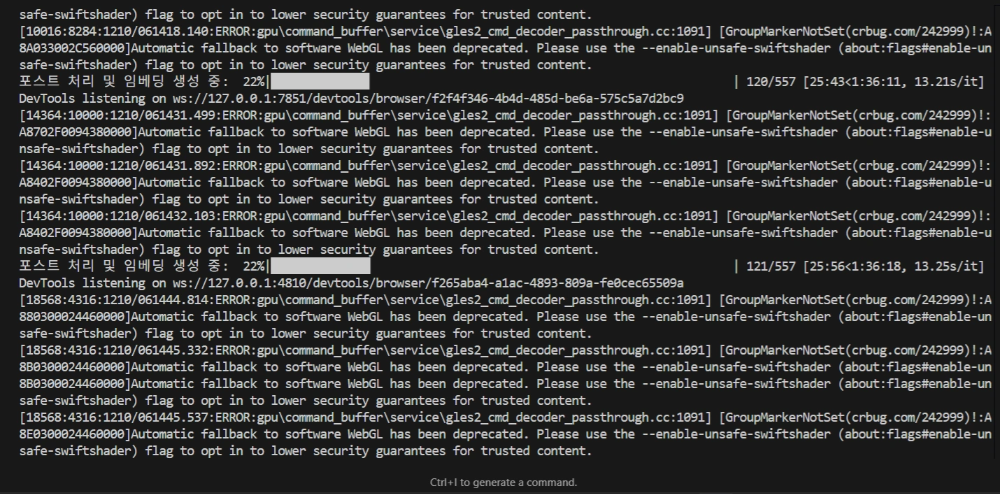

데이터 업로드 스크립트 실행

터미널에서 스크립트를 실행하면 블로그 데이터가 Pinecone 인덱스에 벡터 데이터로 변환되어 저장되는 작업이 시작됩니다. 이 과정을 통해 RAG 시스템의 지식 기반이 구축됩니다.

python ingest_data.py

AI 데이터 베이스 생성 단계별 요약

AI 데이터베이스(Pinecone)를 활용한 벡터 데이터 업로드 과정을 단계별로 요약하면 아래와 같습니다.

- 임베딩 생성

- 텍스트, 이미지, 소리 데이터를 1024차원 벡터로 변환

- 의미 기반 검색이 가능한 Embedding Vector 생성

- 데이터 수집 및 전처리

- 블로그 사이트맵(sitemap.xml)에서 /숫자 URL 추출

- HTML 콘텐츠에서 제목, 본문, 구조화 데이터 정리

- 벡터 업로드

- Pinecone REST API를 사용해 100개 단위로 배치 업로드

- 업로드 시 벡터와 메타데이터(제목, URL) 포함

포스트 처리 및 임베딩 생성

임베딩 벡터(Embedding Vector)는 텍스트, 이미지, 소리 같은 비정형 데이터를 컴퓨터가 이해하고 처리할 수 있는 숫자 리스트로 변환한 것입니다. 쉽게 말하면 단어나 문장의 의미를 나타내는 좌표라고 볼 수 있습니다.

- 수집된 URL에 하나씩 접속하여 HTML을 스크랩합니다.

- 스크랩한 콘텐츠에서 제목, 본문 등을 추출하여 텍스트를 정리합니다.

- 정리된 텍스트를 토큰 청크로 나눕니다.

- 각 청크를 multilingual-e5-large 모델을 사용하여 1024차원의 임베딩 벡터로 변환합니다.

Pinecone은 단순한 벡터 저장소를 넘어, AI 애플리케이션을 효율적이고 안정적으로 운영할 수 있게 해주는 강력한 플랫폼입니다. 텍스트, 이미지, 소리 등 다양한 형태의 데이터를 1024차원 임베딩 벡터로 변환하고, 의미 기반 검색과 유사도 계산을 통해 정확한 결과를 제공합니다.

개발자는 서버 관리나 인프라 고민 없이 데이터와 AI 모델의 연결에 집중할 수 있으며, Pinecone의 자동 확장성과 높은 안정성 덕분에 대규모 서비스 환경에서도 문제없이 운영이 가능합니다.

즉, Pinecone을 활용하면 AI 기반 추천 시스템, 문서 검색, 챗봇, 이미지 검색 등 다양한 애플리케이션을 빠르고 효율적으로 구축할 수 있으며, 사용자 경험과 서비스 품질을 동시에 높일 수 있습니다.

AI 프로젝트를 시작하려는 기업과 개발자라면, Pinecone은 반드시 고려해야 할 필수 솔루션이라고 할 수 있습니다.

자주 묻는 질문 (FAQ)

Q1. Pinecone이란 무엇이며, 일반 데이터베이스와 다른 점은 무엇인가요?

Pinecone은 데이터를 고차원 벡터로 변환해 저장하고 검색할 수 있는 관리형 AI 벡터 데이터베이스입니다. 일반 SQL이나 NoSQL 데이터베이스는 키-값 조회에 강점이 있지만, 의미 기반 검색이나 유사도 계산에는 한계가 있습니다. Pinecone은 이미지 검색, 문서 검색, 추천 시스템, 챗봇 등 AI 애플리케이션에 최적화된 유사도 기반 검색 기능을 제공합니다.

Q2. Pinecone을 활용해 AI 데이터를 관리하려면 어떤 과정이 필요한가요?

Pinecone을 활용하려면 크게 다음과 같은 단계가 필요합니다. ① 회원가입 후 프로젝트 생성 및 모델 선택(예: multilingual-e5-large), ② API 키 확인 및 환경 설정, ③ 블로그 또는 데이터 소스에서 URL 수집 및 HTML 콘텐츠 스크래핑, ④ 텍스트, 이미지 등의 데이터를 임베딩 벡터로 변환, ⑤ Pinecone REST API를 통해 벡터와 메타데이터를 업로드합니다. 이를 통해 AI 기반 의미 검색과 추천 시스템 구축이 가능합니다.

Q3. Pinecone의 주요 장점과 기능은 무엇인가요?

Pinecone의 주요 장점은 다음과 같습니다. ① 실시간 벡터 검색: 대규모 데이터에서도 빠른 검색 속도 제공, ② 완전 관리형 서비스: 서버 관리 없이 자동 확장 및 최적화, ③ AI 애플리케이션 통합: Python SDK, REST API, 다양한 ML 프레임워크 지원, ④ 높은 정확도: 유사도 기반 정확한 결과 제공, ⑤ 뛰어난 확장성: 수십억 개 벡터 처리 가능. 이를 통해 개발자는 데이터와 AI 모델 연결에 집중할 수 있습니다.

Q4. Pinecone에서 임베딩 벡터란 무엇이며, 왜 필요한가요?

임베딩 벡터는 텍스트, 이미지, 소리 등의 비정형 데이터를 컴퓨터가 이해할 수 있는 고차원 숫자 리스트로 변환한 것입니다. 쉽게 말하면 단어나 문장의 의미를 나타내는 좌표라고 볼 수 있습니다. Pinecone은 이 임베딩 벡터를 활용해 의미 기반 검색과 유사도 계산을 수행하므로, 추천 시스템, 문서 검색, 챗봇 등 AI 서비스 구축에 필수적입니다.

Q5. Pinecone을 사용하면 AI 애플리케이션 개발에서 어떤 이점이 있나요?

Pinecone은 데이터 저장, 임베딩 관리, 검색 기능을 한 곳에서 제공해 개발 효율성을 높입니다. 서버 관리 부담 없이 AI 모델과 데이터를 연결할 수 있고, 실시간 유사도 검색과 높은 정확도로 사용자 경험을 개선할 수 있습니다. 또한 자동 확장성과 안정성 덕분에 대규모 서비스 환경에서도 문제없이 운영할 수 있습니다.

AI Vector Database Pinecone: A High-Performance Data Platform for RAG Systems and Vector Search